Nachgefragt: Was ist nur mit dem Internet los?

In der Vergangenheit habe ich immer häufiger mit Leuten gesprochen, die sehr eigenartige Beobachtungen gemacht haben. Auch mir ist das schon passiert und ich konnte es mir nicht erklären. Der Gedanke ist eigentlich absurd, aber wird das Internet gecached, also sprich zwischengespeichert und das Gespeicherte ausgeliefert? Das wäre fatal und die absolute Kontrolle über jede Information. Es fällt mir sehr schwer, den Artikel zu schreiben, eben weil es so absurd klingt. In einigen Sätzen werde ich erklären, was mich so verwirrt und welche Gedanken ich mir darüber gemacht habe.

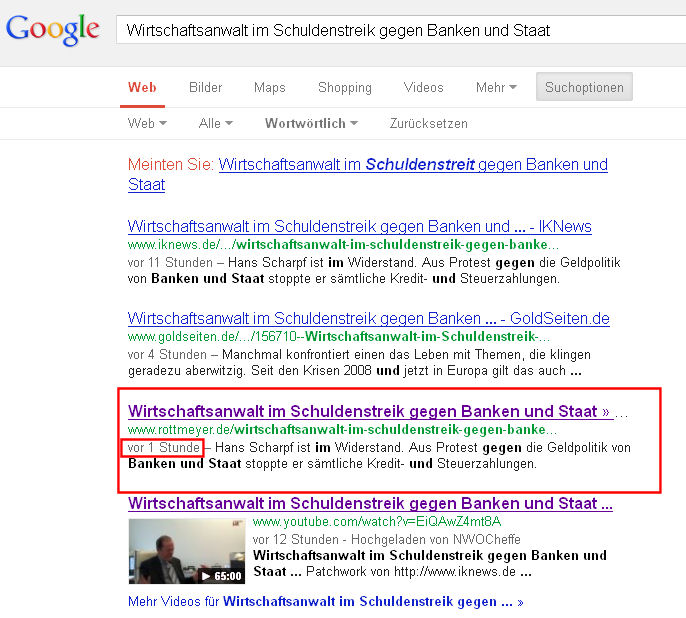

Zunächst einfach ein Screenshot, der bereits einige Fragen aufwirft. Dieses ist nur eine der Anomalien, welche in der näheren Vergangenheit auftraten. Es gilt, auf das rot Umrandete zu achten.

Es geht um meine Domains, www.iknews.de und die alte www.infokriegernews.de. Beide laufen in der gleichen Datenbank und auf dem gleichen Server. Es gibt dort eine Verzögerung, die sich nicht erklären lässt, selbst der Counter hat eine Differenz von 300 Aufrufen. Beide Fenster habe ich zeitgleich aktualisiert.

Es kam auch in der letzten Zeit mehrfach vor, dass man mit Leuten schrieb und denen gesagt hat, sie mögen mal auf diese oder jene Webseite gehen und die sahen den Artikel nicht. Heute ein weiteres sehr eigenartiges Beispiel. Um zu sehen, wie sich der Artikel mit Herrn Scharpf entwickelt, googelte ich die Überschrift.

Frank hatte den Beitrag laut Google in seiner Kategorie „Aufgelesen“ aufgenommen, ich klickte den Link und sah den Artikel auch bei Rottmeyer.de. Dann wollte ich schauen, in welche Kategorie er ihn gesetzt hatte und war erstaunt, der Artikel war nicht da.

Hier zwei Screenshots, einmal Google und dann 1,5 Stunden später von Rottmeyer.

Ca. 1,5 Stunden nach der Googlesuche entstanden:

Ich fragte Frank, ob er was geändert hat oder ob er WP-Cache benutzt und er verneinte das. Es gab in der letzten Zeit bei einigen Leuten auch auf anderen Webseiten derartig unerklärliche Verzögerungen.

Mit diesem Artikel möchte ich die Leser bitten, zu posten, wenn ähnliche Erfahrungen gemacht wurden. Ich habe mir den Kopf zerbrochen, komme aber nicht auf eine Lösung. In diesem Zusammenhang möchte ich noch einmal auf folgende Artikel hinweisen.

http://www.iknews.de/2010/08/04/internet-notausknopf-jetzt-in-den-usa/ (DNS bzw DNSSEC)

http://www.iknews.de/2012/03/18/uberwachung-der-superlative-echelon-ist-schnee-von-gestern/(Utah DATACENTER)

http://de.wikipedia.org/wiki/Ipv6 (IPv6)

Der Artikel ist nicht als Fakt zu sehen, sondern dient, die Verwirrungen zu klären. Je mehr Daten zur Verfügung stehen, umso schneller ließe sich ein Muster dahinter erkennen. Lags von Sekunden ließen sich schwer, aber halt irgendwie erklären, Lags von Stunden, die zum Teil ISP-abhängig sind, lassen sich so nicht erklären. Ich bin für jede Erklärung dankbar.

Carpe diem

72 Responses to Nachgefragt: Was ist nur mit dem Internet los?

Schreibe einen Kommentar

Du musst angemeldet sein, um einen Kommentar abzugeben.

, FXCM

, FXCM

Gerne hätte ich noch den Link zu einem Artikel über Facebook gepostet wo ich über einen Feldversuch geschrieben habe. Facebook blendete bei einer Gruppe von Menschen bewusst Informationen aus um zu sehen wie sich das auf die Verbreitung von Informationen auswirkt, leider kann ich den Artikel nicht finden.

Wenn jemand da einen Artikel zu weiß bitte posten.

Hi Jens,

um es ganz kurz zu machen: Das liegt am lokalen Browser Cache und hat nichts mit dem Internet an sich zu tun.

Wenn du die Webseite unter zwei verschiedenen Domainnamen aufrufst, kann es sein, dass dein lokaler Browser unter den beiden Domainnamen im lokalen Browser-Cache eine unterschiedliche expire Time hat.

Sorry, kann ich nicht glauben. Bei mir ist dasselbe wie bei Jens. Unter iknews alles aktueller, als unter infokrieger. Bei Seitenaufrufe ist es ganz krass: 1779 zu 1334. Auch dein, dieser Kommentar ist unter infokrieger nicht zu finden…

Nachtrag: klickt man den Artikel unter infokrieger an, erhält man die korrekten anzeigen. muss aber daran liegen, daß man dann auf iknews ist.

Chris ich habe das mit unterschiedlichen Browsern und Computern ausprobiert, leider ist es nicht so trivial. Und das Artikel 1-2 Stunden nicht erscheinen wird kaum am Browsercache liegen?!?

PS: Ich weiss schon wie man den Browsercache leert, strg + shift + r oder f5 aber es ist nicht der Browsercache.

ich habe jetzt unter infokrieger stehen:

links unter nne: urugay der staat als drogenhändler,

zähler steht auf 1334, letzte kommentare steht dein erster kommentar unter diesem artikel

zeit: 22:30

Bei mir sind beide Seiten synchron. Würde auch den Browsercache vermuten. Prinzipiell sind aber auch Latenzen bei Domainaktualisierungen möglich, die dann ISP-abhängig und Standortabhängig auftreten können. Wer selbst mal Webspace, oder eine Domain registriert hat kennt die typischen Sätze wie:

„Bitte beachten Sie, dass ein neuer Domainname in Einzelfällen noch nicht sofort von überall erreichbar ist.

Die Bekanntmachung eines Domainnamens im gesamten Internet benötigt bis zu 48 Stunden.“

Wo liegt das Problem?

Ob sie nun zwischen cashen oder nicht.

Schreibt hier irgend jemand was, was der Demokratie widerspricht?

Wenn man zwei unterschiedlich schnelle Seiten hat mit dem selben Inhalt, dann nimmt man halt die schnellere Seite.

Sich Gedanken darüber zu machen ist Zeitvergeudung, denn wenn sie den „Killswitch“ ziehen (sofern die Schwätzer so etwas überhaupt haben), dann ist doch eh alles Zappenduster.

und ob wir das im Vorhinein gewusst haben, das kann dann doch eh keiner mehr lesen, oder?!?

Vieles liegt auch am Host… ich hab zum Beispiel einen Kunden, wenn ich dort ein simples HTML-Dokument per FTP hochlade, ist dieses teils erst 30 Minuten später über das Internet erreichbar. Dieser Host ist übrigens in den Staaten und war sehr günstig, also nicht verwundernswert.

Hi Jens,

es gibt noch eine andere Variante: Manche Webhoster tun Seiten bzw. Datenbankaufrufe zwischencachen um Traffic bzw. teilweise auch Datenbankzugriffe zu sparen.

Daran könnte es evtl. auch liegen! (dann hat es nichts mit deinem lokalen Browser Cache zu tun)

Wenn Umstellungen stattfinden, dann finden die nicht zeitgleich statt, erst recht nicht, wenn das weltweit riesige Dimensionen annimmt. Sprich: Das eine kann schon in die „Aktualisierung“ einbezogen sein, das andere noch nicht.

Welche Art der technischen Aktualisierung oder Updates das konkret betrifft ist sehr vielfältig. Das kann auf der einen Seite ein reiner technischer Vorgang sein, das kann aber wie Jens auch angedeutet hat, natürlich mit IPv6 oder der Utah Superbase etc. zu tun haben.

Ich will mal formulieren was uns im Firmenbereich so tangiert. Da gibt es z.B. die sog. Deduplizierung:

http://de.wikipedia.org/wiki/Deduplizierung

>> Deduplizierung, auch Data-Deduplication, Datendeduplizierung (engl. Deduplication), ist in der Informationstechnik ein Prozess, der redundante Daten identifiziert und eliminiert, bevor diese auf einen nichtflüchtigen Datenträger geschrieben werden. Der Prozess komprimiert wie andere Verfahren auch die Datenmenge, die von einem Sender an einen Empfänger geschickt wird. Es ist nahezu unmöglich, die Effizienz bei der Verwendung von Deduplizierungs-Algorithmen vorherzusagen, da sie immer von der Datenstruktur und der Änderungsrate abhängig ist. Deduplizierung ist jedoch die derzeit effizienteste Art, Daten zu reduzieren, bei denen eine Mustererkennung möglich ist (unverschlüsselte Daten).

Kurzform: Es wird derzeit massiv an einem Muster-Caching gearbeitet. Bedeutet: Der Computer soll ähnliche Muster erkennen und diese

DANN NICHT MEHR ERNEUT ÜBER DIE LEITUNG SCHICKEN.

Sprich: Ein Firmenlogo wird erkannt und dann nicht nochmals gesendet. Damit kann man Bandbreiten optimieren.

Eine der Firmen die da ganz gross drin sind, ist die kalifornische Firma Riverbed:

http://www.riverbed.com

Zwischen Empfänger und Sender tritt also ein Mustererkennungsalgorithmus auf. Wie gut der ist, das sei dahin gestellt. Wir kennen ja vielleicht alle so paar Experimente mit Spracherkennungssoftware die wir mal drangsaliert haben. Bzgl. Mustererkennung kennen wir auch die biometrischen Experimente. Zusammengefasst: Der Computer tut sich mit Mustererkennung sehr schwer und da geht vieles gründlich schief.

Teradici ist einer der grossen ZeroClient Hersteller mit einem der leistungsstärksten Protokolle die sich PCoIP nennen. Habe vor paar Tagen gerade 2 Firmengebäude über Funk vernetzt und das war etwas schwierig obwohl PCoIP schon verdammt gut ist. Ich habe daraufhin meinen Ansprechpartner bei Riverbed angesprochen und gefragt ob es nicht Sinn machen würde ihre vSH (virtual Steelhead) auf dem Server der Firmenzentrale zu installieren.

Ich referenzierte dabei u.a. dies hier:

http://www.teradici.com/pcoip-solutions/network-solutions-partner-program/overview.php

A partnership between Riverbed and Teradici will be a perfect match to further enhance a global organization’s ability to develop a high-performance IT infrastructure

Venugopal Pai

Vice President of Global Alliances

Riverbed

und fragte ihn, wie es denn mit dieser Coop aussieht. Antwort: Sie arbeiten derzeit daran, aber die Lösung von PCoIP + Riverbed ist noch in der Testphase und ich solle erst im Sommer mit einer Lösung rechnen.

Was ist denn jetzt der Unterschied zwischen PCoIP und Riverbed wird der Laie hier fragen und wie soll sich denn das ergänzen.

Ich habe Euch in Offtopic erklärt, dass der Computer der Zukunft eine Streichholzschachtel ist und dass sie den PC, also den personal computer, mit allen Mitteln abschaffen wollen, koste es was es wolle. Das Ziel ist nur noch UCs bzw. ZeroClients zu haben und ein normaler PC wird dann unerschwinglich sein.

Bei einem ZeroClient oder UC zählt dessen Kompressions-Komunikationsleistung. In diesem Punkt ist das PCoIP von Teradici richtig gut und MS will das in seine neuen RDS Server Umgebung im nächsten Jahr aufnehmen. Es werden dabei bestimmte Kompressorkarten zum Einsatz kommen, RemoteFX was MS derzeit preferierte wird wohl dann Geschichte werden, wenn der PCoIP Durchbruch kommt.

Alle die jetzt mit Aktien spielen aufgepasst: Da könnt Ihr Geld investieren weil die beiden Firmen hoch kommen. Jens kann Euch besser erklären wie man da reininvestiert, das ist nicht mein Fachgebiet. Ich habe damals gesagt, dass Apple hoch kommt. Man glaube mir nicht. Heute jammern mich Wirtschaftsfachleute an und sagen sie hätten damals besser auf mich gehört. Technische Zukunft ist vielfach recht gut voraussehbar und so auch das UC-Netz (also der Nachfolger des Internets) und der ZeroClient. Dass man dazu ein gescheites Protokoll braucht, ist ja wohl klar und darin ist Teradici aus meiner Sicht der beste. Ich habe da schon paar Experimente gemacht! In meinem Fall muss ich z.B. Multimonitorbetrieb (Workstationbetrieb) über Funk hinbekommen. Das ist nicht leicht und Teradici hat das im Griff.

ABER!

Da gibt es dennoch die Optimierung des Datenflusses und da kommt jetzt Riverbed ins Spiel. Sie optimieren den Datenfluss eben durch Deduplizierung was eben bedeutet, dass er wiederkehrende Muster erkennt und diese nicht mehr über die Leitung schickt.

Wie ich aber schon sagte, ist vieles davon derzeit in einem Teststadium. Ich will nicht wissen wie gut diese Deduplizierungsalgorithmen wirklich funktionieren und welche Provider da schon mitmachen usw. Sprich: Nicht jeder muss von diesem Phänomen betroffen sein. Mein Apa bei Riverbed sagte dass wir bis Sommer warten sollen weil dann die Sache ausgereifter sei. Sprich: Sie experimentieren gerade mächtig damit rum.

Am Ende der Leitung können dann eben Phänomene bei dieser neuen Caching-Technik auftauchen. Jens hat also mit der Vermutung Caching sei an dem Phänomen schuld aus meiner Sicht generell mal Recht und Einwände bzgl. Browser Cache wie von chris89 gebracht sind natürlich auch immer in dieser Kette zu bedenken. Die Frage ist auf welcher Ebene und wer hier zu welchem Zweck cacht. Wie ich schon sagte, der UC macht eigentlich nur die alte Kompression und Flusskontrolle im Sinne der Leitungsqualität, aber nicht die Mustererkennung. Das von Jens beschriebene Phänomen deutet aber auf die Mustererkennungsalgorithmen hin das im Falle diverse Provider bereits bei sich testen. Betonung liegt auf TESTEN. Wie ich aus dem Firmenbereich erfuhr sind wir ja derzeit bei Riverbed diesbezüglich in der Testphase und wir sollen noch bis Sommer warten.

Da kommen viele Faktoren zusammen.

Wenn ich bei mir auf der Webseite was ändere, sehe ich das mitnehmen t-online Anschluss sofort. Über unitymedia dauert es dann ein paar Stunden bis man die Änderungen sieht.

Sicher liegt es daran nicht. Zumal es unterschiedliche Hoster und Webseiten betrifft.

Noch als Ergänzung zu dem oben gesagten:

Ich war kürzlich auf einer Supercomputing Tagung. Sprich: Die richtigen grossen Computer in Garching, Stuttgart und Jülich (auf DE bezogen).

Die sehen z.B. so aus:

http://de.wikipedia.org/wiki/SuperMUC

Innen sieht das so aus:

http://www.sync-blog.com/wp-content/uploads/2012/06/supermuc.jpg

Wer hier Ähnlichkeiten mit AKWs sieht, liegt im Sinne des Utility Computings, also des Versorgungs Computings gar nicht mal so falsch!

Hier ist z.B. ein Bild von den Bauarbeiten an diesem „2. digitalen Reaktorblock“:

http://www.heise.de/imgs/18/6/0/5/6/8/7/LRZ-2010-07-Foto-Ernst-Graf-hoch.jpg-5b21f83f04384aab.jpeg

Auf dieser Tagung war z.B. eine Firma welche Probleme sah ihre kompletten Videoaufzeichnungen der Fernsehsendungen zwischen München und Brüssel hin und her zu schieben. Der Sprach also von Peta- und Zetabyte an Daten (PBytes, ZBytes).

Es sieht so aus, dass das technisch nicht möglich ist. Da kannst Du viel komprimieren und deduplizieren, diese irren Mengen bekommst Du nicht durch die Leitungen. Ich meinte: Na, dann eben 2 Autos die ständig von und nach Brüssel mit den Bändern fahren, was sonst? Genau genommen: Das ist wohl die einzige derzeitige Lösung. WAN Leitungen schaffen diese Grössenordnungen nicht. Es waren dann noch paar andere Firmen da mit genau demselben Problem und es wurde klar, dass es ein riesen Problem mit den gigantischen Datenmengen gibt, von Datensicherung ganz zu schweigen.

Kommen wir auf das Bild oben mit dem „digitalen Reaktorblock“ zurück. Wenn dort ein Flugzeug reinfliegt und das Teil fliegt in die Luft, dann sind ne grosse Menge Daten (insbesondere wissenschaftliche) auf nimmer Wiedersehen verloren.

Man arbeitet also mit Hochdruck daran die Datenmengen irgendwie besser in den Griff zu bekommen. Sowohl bzgl. Verteilung, als auch bzgl. Datensicherheit. IBM seinerseits hat auf der Tagung neue LTO Bänder angekündigt mit gigantischen Speicherkapazitäten usw. Das ist aber jetzt mehr die technische Diskussion die ich hier auslasse.

Wie erwähnt scheidet das Browsercaching aus. Drei Browser auf 4 unterschiedlichen PC´s mit diversen refreshraten, no way.

Wenn ich jetzt mal zu spinnen beginne….

Zur Erinnerung hier ein Artikel zur diminished reality : http://www.iknews.de/2011/10/14/diminished-reality-die-angepasste-realitat/

Nehmen wir mal zum Spass an, dass Webseiten die – sagen wir mal kritisch berichten in irgendeiner Art und Weise zwischengecached werden. Und im Bedarfsfall einfach unliebsame Inhalte ausgefiltert. Wenn der Link direkt verschickt wird geht es ja witzigerweise sogar. Das wäre wesentlich effektiver als das Abschalten wo die Menschen erst richtig neugierig werden. Nur ein Gedanke, keine Wahrheit.

Bei der Umstellung auf solche Systeme wäre ein Bugfreier Übergang aus technischer Sicht ausgeschlossen, weil IMMER irgendwas irgendwie hakt, egal wie gut die Leute sind die das coden. Jeder Coder wird verstehen was ich meine. ES GIBT keine BUGFREIE Software.

Ich habe bereits einige fähige Softwareentwickler darauf angesprochen und bisher konnte sich keiner das Phänomen erklären. Wie gesagt es betrifft ja nicht nur meine Webseite. Um ein genaueres Bild zu bekommen habe ich ja diesen Artikel eröffnet um möglichst viele Daten zu bekommen wo wer wann so etwas erlebt hat. Gut wäre mit einer kleinen Auflistung.

Browser

Version

Webseite oder CMS

Art des Phänomens

Ich habe das bisher effektiv nur auf Blogs festgestellt, aber ich werde jetzt mal intensiver auch andere Seiten beobachten.

Hi Jens,

das von dir beschriebene Szenario ist technisch nicht möglich.

Wenn Webseiten durch Provider gefiltert werden würden, dann müsste man die Routen manipulieren, worüber der Internet Traffic läuft und das würde per traceroute sofort ins Auge stechen.

Weiterhin ist es vollkommen unmöglich, dass Millionen von ISPs weltweit alle genau dieselbe Webseite filtern bzw. vor den Inhalt einen Cache schalten. Das ist de facto technisch nicht möglich.

Hallo Jens.

Ich habe schon sehr viele ähnliche Erfahrungen gemacht!

Aus dem Grund habe ich vor ca. 2 Jahren ein Archiv erstellt, das ich „WTF“ getauft habe …

Das hat sich inzwischen mit vielen Videos gefüllt …

Ich schicke mal Teil 1 und 2 rüber (zusammen etwa 10MB) – bezieht sich auf Youtube Kommentare, die teilweise erst 2 Tage später auftauchten (nach E-Mail Eingang) … . Bitte auf`s Datum achten. Der Browser-Cache wurde natürlich geleert!Ich schicke es an: blecker/at/iknews-redaktion.de

Gruß

@Nver2Much

sehr pragmatisch gedacht.

Das Problem von Jens ist aber ebenfalls Fakt und „lange Laufzeiten“ und „Aufhänger“ meines MAC stelle auch ich in letzter Zeit häufiger fest.

Als „technisch Interessierter“ weis ich, -Nichts ist Unmöglich –

Würde ACTA, NDAA usw. existieren, wenn die Umsetzung „unmöglich“ wäre ?

Sorry, wir werden überwacht – damit rechne ich.

Die gezielte Tötung meiner Person per Drohne dürfte aber im „Preis-Leistungs-Vergleich“ des CIA noch nicht wirtschaftlich sein.

Vorsorglich fliege ich nicht mehr und „hüte“ das Bett !!!

Ich empfehle dir mal ein Abbo der Technology Review 😉 Du wärst erstaunt was alles technisch möglich ist. Wenn ich es verstehen würde und ich habe ein wirklich ganz ordentliches Verständnis, dann hätte ich den Artikel nicht gemaccht oder er hätte einen anderen Titel 😉

Hallo,

Ja, die Internetprovider cashen die Websites.

Der Grund ist, dass man so Webseiten, die von mehreren Benutzern angefragt werden schnell zur verfügung stellen kann statt sie jedesmal neu vom Webserver anzufragen.

Für die genauen Cashingzeiten würde ich mal den Provider Fragen…

Gruss!

@ querulant:

Denkle daran die Updates und

Softwareaktualisierungen aktuell

zu halten, dort werden den neuesten

„Bedrohungen“ begegnet.

Natürlich nicht die Methoden der

Überwachung. Es ist heute ohne viel

Aufwand möglich, das sich jemand auf

Deinen PC aufsetzt. Egal ob MacOs

oder WinOS oder Linux oder oder.

Ausspähungen via Cam, kein Problem….

Zugeklebt/verdeckt? Na dann halt

über das Micro. Tastatur/Monitorscreening?

Kindergarten. Stöbern in deiner/unserer

Cloud? Ein Spaziergang.

@ Jens: Mir als Kommentator ist schon

aufgefallen, das einige Kommentare

im Nirwana verschwunden sind um dann

später wieder zu materialisieren.

Das ist bei Youtube aber auch bei

einigen Blogs der Fall. Bei Dir

konnte ich das noch nicht feststellen,

da wurde bisher alles in Echtzeit

eingestellt.

Also bei mir ist infokriegernews.de aktueller!

Oh und mittlerweile ist bei Opera iknews aktueller und bei ie browser infokriegernews

… in dieser Zeit, wo man die totale Überwachung der Meschen anstrebt sollte man nichts ausschließen.

Seiten wie diese hier werden einigen garantiert ein „Dorn im Auge“ sein, daher wachsam sein!

Alles was nicht durch finanziellen Zwang kontrolliert werden kann(Blogs, freie Journalisten), ist der Gefahr ausgesetzt durch anderen Methoden(Technologien) kontrolliert zu werden.

Es wird getrickst bis sich die Balken biegen.

Hier ein anderes Beispiel, wie der Machtapparat funktioniert.

Herzlich Willkommen in der EUDSSR.

Da in der modernen Planwirtschaft Kinderarbeitslosigkeit bei bis 25 jährigen verboten sein wird, ist im Gegenzug Beschneidung an Kleinkindern erwünscht.

Warum dieses Beispiel es passt so gar nicht zum Artikel….

Nicht ganz, weil vorher stand es so bei Wikipedia unter Zirkumzision:

“Aufgrund Ihrer Empfehlung habe ich ihr Angebot ich solle mich doch mal bei Wikipedia schlau machen und unter Zirkumzision nachschauen.“

http://de.wikipedia.org/wiki/Zirkumzision Das habe ich getan und musste dies zu meinem Bedauern lesen. „Zirkumzisionen sind mit einer signifikanten Komplikationsrate behaftet.[8] Sie wird je nach Definition zwischen 0,06 % und 55 % angegeben[112] bzw. zwischen 2 % und 10 % geschätzt.[113] Auch Todesfälle insbesondere nach der Beschneidung von Neugeborenen, bei denen schon geringer Blutverlust Lebensgefahr bedeutet, kommen vor.[114][115] Einer US-amerikanischen Untersuchung zufolge sterben in den USA jährlich schätzungsweise um die 117 neugeborene Jungen (entsprechen 1,3% aller Todesfälle in dieser Gruppe) an den Folgen von Beschneidungen[116].“

“Das scheint für Sie völlig in Ordnung zu sein. Ich frage Sie allen Ernstes wofür bedanken Sie sich bei Herrn Prantl , doch nicht etwa für die Todesfälle in den USA durch Beschneidung.“

Jetzt steht es wie folgt:

Zirkumzisionen sind mit einer signifikanten Komplikationsrate behaftet.[8] Sie wird je nach Definition zwischen 0,06 % und 55 % angegeben[130] bzw. zwischen 2 % und 10 % geschätzt.[131] Auch Todesfälle insbesondere nach der Beschneidung von Neugeborenen, bei denen schon geringer Blutverlust Lebensgefahr bedeutet, kommen vor.[132][133]

Ihr seht also Aufgrund des Ersterbens einer einzelnen Person, wurde dieser Artikel bei Wikipedia manipuliert.

Das deutsche Stimmvieh wird bewusst manipuliert(gesteuert) und findet es toll bzw. gefallen daran.

Die Politik steht sich nicht im weg sondern sie ist PROGRAMM und läuft nach PLAN(Wirtschaft).

Man macht die Menschen mit den einfachsten Sachen schon glücklich / gefügig oder noch besser gehorsam. Das Internet ist eine herausragende Einrichtung den Menschen unbeobachtet zu kontrollieren.

Der ITU-Gipfel in Dubai ist ein Kalter Krieg ums Internet so, der Spiegel heute.

Autoritäre Staaten wie China und Russland wollen mit Hilfe einer Uno-Organisation das Internet kontrollieren. Sie könnten dann den Austausch von Daten und Meinungen unterbinden, wenn sie es für richtig halten. Die USA und Europa stellen sich dagegen. In Dubai kommt es jetzt zum Kräftemessen.

Die USA & EUROPA stellen sich nur offiziell dagegen, in Wirklichkeit wird akribisch kontrolliert, die Anonymität wird ausgehebelt. Das cachen von Daten ist reine Routine, man will wissen wie jeder einzelne genau tickt. Der Kostenapparat für den Austausch von Daten und Meinungen wird in den USA & EUDSSR sogar genau aus diesem Grund mit Milliarden subventioniert.

Please use our social Network,for a later treatment as usual.

George Orwell is comíng soon. 😉

„Wer die Vergangenheit kontrolliert, der kontrolliert die Zukunft; wer die Gegenwart kontrolliert, der kontrolliert die Vergangenheit!“

Und ich dachte mir in den 90igern, wie das war es jetzt.

Na super-toll,falsch gedacht, das war erst der Anfang. 🙂

Na ja wenigstens wird einem nicht langweilig dabei und man muß sich ständig etwas neues einfallen lassen um diese Spinner zu beschäftigen. ggggggg 🙂

Ich habe auch Merkwürdigkeiten festgestellt. Seit du die Seite Iknews.de eingerichtet hast. Vorher bin ich immer auf die Infokrieger-seite gegangen. Jetzt auf der iknews.de stelle ich Unterschiede bezüglich der Liste „letzte Kommentare“ fest. Wenn ich nach einander 2 oder 3 Artikel in einem neuen Tab, also mit rechtsklick öffne, unterscheiden sich die Auflistungen. Das ist wie gesagt aber erst, seit du nach dem ganzen Kuddelmuddel mit deiner Seite und dem nicht auffindbaren Administrator selbst umgestellt hast. Technisch kann ich dir leider nicht helfen. Wenn du möchtest kann ich dir noch zwei Screenshots schicken mit den Unterschieden.

Ich habe den firefox 17.0 und nutze noscript. Auf deiner Seite lasse ich nur das script iknews.de zu. Weil mir das reicht.

Hallo Evey

Die neuesten Kommentare kannst du nur Eingelogt sofort sehen, ansonsten kommen sie erst nach einer Weile.

Da sprichst du ein Thema an! Bei dir ist mir aufgefallen, dass mein Kommentar nicht da war. Habe den Browser-Cache gelöscht und neugeladen, half nichts. Einige Stunden später war der Kommentar da. Ich habe vermutet/vermute, dass du oder ein Moderator ihn erst freigeschaltet hast. Du kannst dazu wohl genaueres sagen.

So nun zu deiner Vermutung. Ich hätte erst auch vermutet, dass es am Browser-Cache liegt, den man z.B. beim Firefox mit F5 oder STRG+SHIT+R komplett neuladen lassen kann.

Allerdings habe ich speziell bei Blog.de so einige interessante Dinge festgestellt.

1. Ich gebe blod.de bei NoScript frei und lasse es laden, logge mich ein und klicke dann auf „Mein Blod.de“. Ich war sehr erstaunt, als ich statt der Übersicht der Artikel der anderen Schreiber, nur ein Feld vorfand, wo ich mich nochmals hätte einloggen können. Dieses Feld hat dort nichts zu suchen und ich war komischerweise nicht mehr eingeloggt.

Erklären kann ich es mir nicht.

2. Seit einiger Zeit sind die Ladezeiten bei Blog.de sehr sehr lang. Viele beschweren sich darüber.

3. Jetzt das für das, was ich mir nicht erklären kann.

Ich schreiben einen Beitrag oder verlinke einen. Dann möchte ich doch etwas ändern und klicke die Option „Ändern“ an. Nachdem ich die Passage, den Link oder sonstiges geändert habe, speichere ich dies.

Das komisch ist jetzt, dass mit zunehmender Häufigkeit die Artikel auf den alten Stand bleiben. Dass heißt, alles was ich eingeben habe ist verschunden, einfach weg, dies passiert nicht nur bei Artikeln, auch bei Kommentaren, wie ich erneut gestern feststellen musste.

Habe alles ausprobiert. Noscript für Blog.de deaktiviert, neu eingeloggt, Daten gelöscht mittels der Browserfunktion, mittels Bleachbit, Cache neugeladen. Nichts aber auch gar nichts hat es daran geändert, dass manchmal meine Änderungen verschwinden.

Könnte natürlich ein internes Problem der blog.de Firma sein, wovon ich mal stark ausgehe.

Eine Speicherung und Überprüfung aller Daten, ich weiß nicht. Aber durchaus möglich, den Hinweis haben „Populis“ die Betreiber von Blog.de selbst geliefert. Dürfte auch für dich, Jens, interessant sein.

Blogforever: Projekt gegen digitales Vergessen

http://www.heise.de/newsticker/meldung/Blogforever-Projekt-gegen-digitales-Vergessen-1654381.html

ok. hast recht. Ich war da noch nicht eingelogt. Hab das jetzt noch mal getestet. Eingelogt gibt es keine Unterschiede. Ich möchte aber meinen, dass es früher nicht so war??!!

Sorry, der Text ist ein wenig durcheinander und es haben sich ein paar Tippfehler eingeschlichen. 😉

Das ist ja unglaublich!!! Dann stehen bald Hinweise an der Eingangstür der Bank „Kinder haften für ihre Eltern“ oder was? Soweit ist es nun schon gekommen. Was aber, wenn die Kinder auch nichts haben?

Aber bald wird ja wohl gamäß der neuen Vorhaben der EU jeder Unter-25-jähriger bald arbeit haben. Ha, das ich nicht lache, wie denn, wo denn?

Oh sorry, Kommentar unter falschem Artikel gepostet.

http://www.ag-nbi.de/lehre/0203/V_NBI/16_Caching.pdf

Jens ich hoffe das nutzt dir was. Ich persönlich glaube noch nicht das wir hierbei auf die „Matrix“ gestoßen sind sondern das es technische Hintergründe hat.

@Alle

Hier wird nix manipuliert!

Des Rätsels Lösung heißt Proxy-Server!

Zitat:

„Die meisten Provider bieten ihren Kunden die Verwendung eines solchen Proxys an. Er kann folgende Funktionen erfüllen:

…

Zwischenspeicher (Cache)

Der Proxy kann gestellte Anfragen bzw. deren Ergebnis speichern. Wird die gleiche Anfrage erneut gestellt, kann diese aus dem Speicher beantwortet werden, ohne zuerst den Webserver zu fragen. Der Proxy stellt sicher, dass die von ihm ausgelieferten Informationen nicht allzu veraltet sind. Eine vollständige Aktualität wird in der Regel nicht gewährleistet. Durch das Zwischenspeichern können Anfragen schneller beantwortet werden und es wird gleichzeitig die Netzlast verringert. Beispielsweise vermittelt ein derartiger Proxy eines Unternehmens den gesamten Datenverkehr der Computer der Mitarbeiter mit dem Internet.“

https://de.wikipedia.org/wiki/Proxy_%28Rechnernetz%29#Dedicated_Proxy_.28Proxy-Server.29

Und warum man diese Proxy-Server nicht „sieht“:

„Daneben gibt es den transparenten Proxy als spezielle Netzwerkkomponente, der sich einer der beiden Seiten gegenüber transparent (nahezu unsichtbar) verhält. Diese Seite adressiert direkt das Ziel und nicht den Proxy. Durch eine entsprechend konfigurierte Infrastruktur des Netzes wird die betreffende Anfrage dort automatisch über den Proxy geleitet, ohne dass der Absender dies bemerkt oder gar beeinflussen kann. Für die andere Seite aber stellt der Proxy weiterhin den zu adressierenden Kommunikationspartner dar, der stellvertretend für den tatsächlichen Kommunikationspartner angesprochen wird.“

https://de.wikipedia.org/wiki/Proxy_%28Rechnernetz%29#Transparenter_Proxy

Und wieder einmal stelle ich fest, während wir uns in der virtuellen Welt im Kreise um das große Nichts drehen, passiert in der Realität genau das, nämlich nichts!

Es wird niemals die Masse überwacht. Diese soll das nur glauben. Und sie glaubt es, weil um die Einzelnen die stellvertretend für alle tatsächlich überwacht werden so ein Bohei gemacht wird, dass jeder glaubt, er wäre der Nächste.

Außerdem kann sich jeder weitgehend vor der Ausforschung seiner Daten schützen. Und das meist auch noch kostenlos.

Nur, das wäre ja mit Aufwand und Arbeit verbunden. Außerdem müssten die Wissenden die anderen aufklären wollen. Doch bereits hier hört der „Spaß“ auf.

Würden sich alle um den Schutz ihrer Daten bemühen, dann könnten die Geheimdienstler ihre Läden schließen.

Aber na ja, des Menschen (Aber)Glaube ist eben sein Himmelreich.

AE-35

Frage nicht verstanden???

@tugrisu

Die Frage lautete, Zitat: „Der Gedanke ist eigentlich absurd, aber wird das Internet gecached, also sprich zwischengespeichert und das Gespeicherte ausgeliefert?“

Antwort: Ja, es wird gecached. Aber nicht zentral und nicht wegen der Kontrolle der Inhalte, sondern aus Gründen der Performance-Optimierung, letztlich also zur Kosteneinsparung.

Hast Du eine andere Frage, oder eine bessere Antwort auf die obige Frage zu bieten?

AE-35

Ergänzung zu oben…:

Es kann durchaus so sein, dass aus Kapazitätsgründen nicht ein, sondern mehrere Proxy-Server verwendet werden.

Um die vorhandene Netzlast auszugleichen schaltet man vor diese sogenannte „Loadbalancer“. Diese leiten die ankommenden Netzanfragen auf den jeweils am wenigsten ausgelasteten Proxy-Server um. Spätestens dadurch und durch den Betrieb mehrerer Proxy-Server, die nie zu 100% einen identischen Datenbestand aufweisen, entstehen Probleme mit der Homogenität der Dateninhalte.

Was man als Anwender/in am anderen Ende der Verbindung sieht, entscheidet die Aktualität des jeweils dynamisch zugewiesenen Proxy-Servers.

Generell sind die sogenannten „Aktualisierungsprobleme“ typisch für alle an einem Netzwerk betriebenen Komponenten.

AE-35

es geht um BEIDE domains, zur SELBEN zeit, über DIESELBE verbindung, aus DENSELBEN browser heraus, mit klar erkennbaren unterschieden.

alle anderen erklärungen sind bekannt und treffen leider nicht zu

Zum Thema FB-Studie glaube ich das Du den Artikel von netzpolitik.org meinst 26.01.2012

https://netzpolitik.org/2012/facebook-studie-das-internet-ist-doch-keine-echo-chamber/

@tugrisu

„es geht um BEIDE domains, zur SELBEN zeit, über DIESELBE verbindung, aus DENSELBEN browser heraus, mit klar erkennbaren unterschieden.“

Mit beiden Domains meinst Du iknews.de und infokriegernews.de?

Wenn ja, dies sind nur zwei Aliase für ein und dieselbe IP: 78.46.7.104

Allerdings werden beide Domainnamen von unterschiedlichen Nameservern aufgelöst, die z.B. differierende Einstellungen bezüglich der Time-To-Live- und Refresh-Werte aufweisen. Selbst bei gleichzeitiger lokaler Seitenaktualisierung bedeutet alleine das schon eine einseitige Zeitverzögerung durch Laufzeitunterschiede.

Sowohl die die iknews.de als auch die infokriegernews.de laufen beim Serverdienstleister Hetzner. Allerdings auf verschiedenen Servern.

Zur selben Zeit heißt nach menschlichem Ermessen „gleich“. Die Elektronik folgt hier ihren eigenen Regeln. Entweder eine der beiden Anforderungen kommt einen Tick eher an. Oder sie kommen zwar gleichzeitig an, werden aber von dem Loadbalancer an unterschiedliche Server weitergeleitet, um durch Lastverteilung den Performance-Erhalt zu gewährleisten.

Wenn der Browser im „Privaten Modus“ läuft, spielt sein lokaler Cache hierbei keine Rolle.

Verschiedene Proxys gleich unterschiedliche Aktualität gleich unterschiedliche Anzeige.

Wo ist das Problem?

Hie glaubt doch wohl hoffentlich niemand, dass da ein kleines grünes Männchen sämtliche Inhalte kontrolliert und nach seinen Wünschen modifiziert, oder?

Es kann natürlich sein, dass ich mich bezüglich meiner Lösung oben irre, aber so viel ist sicher, dass alles hat schlicht und einfach technische Hintergründe.

Meinste nicht?

AE-35

AE-

Load-Balancing etc sind mit bekannt aber erklären auf keinen Fall häufigere Timelags von bis zu 1,5 Stunden. Eine solche Lifetime würde niemand der bei Verstand ist dort einsetzen und warum sind es Seiten von unterschiedlichen Betreibern, bei unterschiedlichen Hostern und unterschiedliche ISP´s? Ich habe mir da wirklich schon den Kopf zerbrochen und bin nicht auf eine logische Erklärung gekommen.

@Jens

Das Loadbalancing ist ja auch nur ein Teil meiner Erklärung. Der andere und der für die zeitliche Verzögerung wichtigere sind die Proxys. Diese können durchaus recht unterschiedliche Aktualisierungszyklen verwenden. Und je nachdem zu welchem Proxy Deine Anfrage gerade weitergeleitet wird, hast Du mal eine aktuelle und mal eine veraltete Seite.

In jedem Fall, ist die Ursache eine Technische, oder, und das ist gar nicht so unwahrscheinlich, eine Finanzielle (Sparmaßnahmen im Wirtschaftswunderland BRD!), aber nicht irgendwelchen Überwachungsmaßnahmen geschuldet.

Das was wir nicht merken sollen, wie etwa eine heimliche Überwachung, dass werden wir auch nicht merken.

So dumm sind DIE nun auch wieder nicht.

Wer den gesamten Datenverkehr kontrollieren will, muss „nur“ an die Hauptknotenpunkte der ISP’s gehen und die dort durchfließenden Daten doppeln. Dann kann er sie in aller Ruhe und unbemerkt von der Außenwelt speichern und ihrer Auswertung zuführen.

Dagegen hilft nur eine hoch verschlüsselte Kommunikation. Doch Verschlüsseln ist ja sowas von Bäh bei den Infokrieger-Helden.

Und wie echte Helden so sind, die wollen eben jung sterben, gelle?

Also, immer schön so weitermachen und bloß nicht jammern…

AE-35

PS: Nimm meine Kritik am Ende meines Kommentars nicht persönlich, denn diese richtet sich an ALLE!

Solange das Kollektiv der Nutzer/innen nicht lernt – und bisher hat noch kein Kollektiv etwas gelernt – seinen Datenverkehr zu schützen. Solange werden wir sporadisch belauscht, ausgeforscht, analysiert und schlussendlich gelenkt. Und dazu braucht es keine Dauerüberwachung der Massen. Man muss nur anhand genügender Beispiele die Prinzipien verstehen, nach denen die Menschen ticken. Danach reichen entsprechend gestaltete Kampagnen, um den gesamten Verein (meint uns alle) in die Irre zu führen.

Wer das nicht glaubt, weil er sich für selbst für überlegen hält, der glaubt auch, dass er drei Flaschen Schnaps trinken kann, ohne am Ende betrunken zu sein.

Aber sei’s drum!

@AE35-Team!

Oh weh, ich sage besser nichts mehr! Wer Augen hat zu sehen, der sehe und wer Ohren hat zu hören, der höre …

>> drei Flaschen Schnaps trinken kann, ohne am Ende betrunken zu sein

DAS ist nur ein Teil. Er ist nicht nur ein MANN (Mädchen sei wachsam ;-), er ist ein Team, aber egal …

>> Solange das Kollektiv der Nutzer/innen nicht lernt – und bisher hat noch kein Kollektiv etwas gelernt – seinen Datenverkehr zu schützen.

A: Ich sagte ja schon: REGIONALE TEAMS, CAMPING MACHEN! Läuft bei uns schon gut, also nur keine falschen Vorstellungen, dass ein Kollektiv NICHT funktionieren könnte. Und das tragen wir auch in die Berufswelt. Ich treffe täglich Leute vom CAMP.

Wegen dem Internet. Sorry, dass ich es so offen sage, aber das Internet interessiert mich täglich weniger!

Obwohl ich also täglich damit zu tun habe, distanziere ich mich davon täglich weil ich GENAU DAS ENDE VOR AUGEN HABE. Und da muss ich mir nicht noch wie Jens lastminute „die letzten Schweinereien“ reinziehen.

Das erinnert mich an diese Fachzeitschriften-Psycho nach dem Motto „finden sie die Geheimnisse die ihnen Microsoft verheimlicht …“ Alles bullshit. Dass MS Dinge verheimlicht ist der eine Teil, dass es egal ist, das ist ein anderer Teil. Denn EGAL wird des dann, wenn Du Dich von diesem Gesangsverein verabschiedest und Deine eigenen Lösungen entwickelst.

Ich sagte es damals schon x mal, ich sage es wieder: DU bestimmst die Zukunft der Technik durch das was DU willst und DU definierst und nicht durch das was DIE ELITE will und DIE ELITE definiert. Technik ist nicht ein Alleinstellungsmerkmal der Elite. Das wird uns heute nur so suggeriert. DAS IST FALSCH!

Technik ist wie es immer schon war ein WERKZEUG um einem EINFACHEN MENSCHEN das LEBEN AUF DIESER MÜHSAL BELADENEN ERDE ZU ERLEICHTERN. Technik ist aus meiner Sicht etwas VON DEM MENSCHEN FÜR DEN MENSCHEN.

ES IST NICHT: VON DER ELITE ein GNADENSERWWEIS für den SKLAVEN!

Sorry, aber Jens kann sich da viel Gedanken darüber verlieren warum die Website X vor der Webiste Y aktualisiert wird. Das ist mir eigentlich ziemlich Schnuppe weil es keine Langzeitbedeutung hat. MORGEN SCHON wird Website Y wieder viel schneller als Website X aktualisiert und wieder weiss angeblich „keiner warum“. Diese Verarschungen von A-Z oder von 1 – 26 brauchen wir nicht immer wieder von neuem beginnen. Es langweilt langsam! Es ist egal, wenn bestimmte Dinge nur durch INSIDERWISSEN erkannt werden KÖNNEN und man von den Usern eine GLAUBENSLEHRE verlangt, damit sie irgenwas glauben was ihnen diese Insiderclique vormacht.

Das ist alles völlig egal. LEUTE, lasst Euch gesagt: Wichtig ist das regionale Tema was Ihr aufbaut und mit dem ihr Dinge vor Ort bewegt die WIRKUNG ZEIGEN, die ERKENNBAR sind. Lasst Washington DC und die Internet-Scheisse Stück für Stück zurück in der alten Welt. Die Elite sieht darin die Zukunft, IHR HINGEGEN habt hoffentlich eine andere Zukunft definiert und gefunden. Und die könnt Ihr nur mit Eurem Nachbarn gut gestalten wenn Ihr wirklich die Dinge um Euch herum neu gestalten wollt.

Ich frage mich manchmal: Höre ich noch Nachrichten? Wann habe ich zuletzt Nachrichten aus Radio oder Fernsehn gehört? MUSS ich noch Nachrichten hören? Meine Antwort: NEIN, ich brauche diesen Schrott nicht mehr! Ich bin unwissend und lebe damit sehr gut, denn ich arbeite LOKAL und VOR ORT an viel wichtigeren Dingen als diesem ganzen GLOBO-SCHEISS-DRECK!

Wenn Ihr sagt: Wow, ein lokales Team hat da was gefunden, das finde ich geil, das will ich auch umsetzen, dann sínd wir daran die Welt zu verändern, die Gemeinschaft um uns herum für etwas zu gewinnen und diesem Elite-Globo-Hokuspokus ein Ende zu bereiten.

Aber das entscheidende ist doch wohl: AUS NICHTS KOMMT NICHTS! Den A. müsst Ihr dafür schon hoch bekommen und um Euch herum Freunde finden! Ich habe es geschafft und ich sage Euch: Macht es auch so!

Zum Ende noch ein Beispiel von gestern: Ich fahre nachts auf dem Weg nach Hause an einer Tankstelle vorbei. Ich sehe wie jemand sein Auto schieb. Ganz spontan beginne ich so zu denken wie das Muster uns gelernt hat zu denken: „Lass ihn doch schieben, Du hast wichtiger Dinge zu tun!“ Ich bin 300 Meter weiter gefahren, ich bin umgekehrt und habe gesagt: NEIN, das wichtigste was ich habe ist, dass dieser Mann sein Auto NICHT SCHIEBEN MUSS und NICHT DIE GANZE NACHT IN SCHNEE UND REGEN STEHEN MUSS bis sich mal ein einsamer Samariter findet der ihn rettet. DENN BEI UNS, DA SIEHT DIE WELT ANDERS AUS! BEI UNS, DA HILFT DER EINE DEM ANDEREN, BEI UNS, da bleibt keiner einfach im Schnee stecken und allen ist es Scheiss egal.

Ich traf also bei dem Auto an und da war ein sichtbar arabisches Pärchen: Der Mann jung und die Frau bildhübsch und verschleiert! Die Frau ist dann sofort in das Auto zurück gegangen. Ich habe von Ihr nichts mehr gesehen. Anscheinend hat ER geschoben und die Frau sass am Steuer. Der Mann hat sich ab da in der COM um mich gekümmert. Wir haben das Auto wieder zum Laufen bekommen und wisst Ihr was: Es hat mir Freude bereitet einem offensichtlichem Muslim und seiner verschleierten Frau zu helfen. Warum? Weil ich diese Ehrlichkeit und Offenheit 100 mal mehr akzeptieren kann als diese Verlogenheit der anderen Partei(en).

Und morgen werde ich diesen Mann wieder treffen. Er und seine Frau werden sagen, dass Christen vielleicht doch nicht so Arschlöcher sind als sie vorher dachten und wir werden danach GEMEINSAM denken und handeln. Das nenne ich regionaler Gedanke. Wir gemeinsam vor Ort bauen neues auf und die ganzen Grosskupferten aus der Globo-League, die können uns mal kreuzweise!

Es gibt keine Feindschaft zwischen uns Christen und den Moslems oder den Juden ausser sie ist künstlich geschaffen. Wenn wir alle guten Willens sind, dann schaffen wir die Welt in der wir leben in und durch uns selber. WIR sind unseres eigenen Schicksals Schmied. Und das ist Prio, nicht diese Internetscheie die ausser Kontrolle gerät und die wir eh nicht mehr retten können (meine Meinung!). Ich vergeude nicht unnötig Energie in eine Sache die praktisch gestorben ist. Für mich ist das Internet was es mal war tod. Dass wir hier noch auf der alten Plattform agieren ist einfach noch der letzte Atemzug eines aussterbenden Systems. Klar: Mancher Sterbender merkt nicht, dass er schon kurz vor dem Ende ist. Aber das ist egal. Man muss aber einen Sterbenden nicht mit allen Mitteln versuchen zu retten wenn die Unausweichlichkeit von dessen Tod eigentlich wissenschaftlich eindeutig ist. An alle Religiösen hier: Ja, wenn Gott … Klar, aber „wenn Gott …“ dann hat er auch den menschlichen Arzt nicht mehr nötig, dann überlebt er auch seine irdische Krankheit etc. überirdisch, nicht wahr?

Der Ikn.news DNS Server leidet unter URL (Cache) oder besser noch Standort Poisoning. 😉

Im einen werden Wetterdaten veröffentlicht und immer wieder betont das Wetermanipulations Mindcontroll und Vergiftungs Trails nicht geben kann.

Und im anderen wird gezeigt wow wir sind alle ausspioniert, weil ein Hoster schneller ist als der andere.

Und während dessen macht der Vatikan und die Rothschilds weiter um ihre NWO zu bekommen.

NWO = New World Order = Neue Welt Ordnung Zufälle gibts.

Na da schaffen doch die BRDigungs Parlamente sehr gut mit den Anglozionistischen zusammen eine Abkürzung ist für uns alle geltend.

Die Jungs wären ja nicht schlecht wenn deren New World Order oder besser gesagt deren Neuen Welt Ordnung nicht ans Tageslicht gekommen wären.

Scheiß auf die NWO.

Oder besser gesagt fuckse Energiesparlampe

http://www.youtube.com/watch?v=inC_zWsmuus

Über so viel Intelligenz von uns allen, das wir das alles zulassen und Menschen des Autismus der Lüge des Störenfrieds und des Nichtdenken bezichtigen nur um unsere Lohnsklaverei hoch zu halten.

Dafür habe ich hier einen Juchitzer

Juhuu

wir sind so gscheit.

http://www.youtube.com/watch?v=yOvR68EJRLM

Bei den Twin Towers da kann ja jeder gleich losträllern…

http://www.youtube.com/watch?v=JFSq3bZsdhQ

In Freifall Geschwindigkeit zusammen gesackt…?!?!!!

Abbruch WTC I, Abbruch WTC II, Abbruch WTC VII

Ist das nicht ein Aufbruch für uns?

@Nver2Much

„Und im anderen wird gezeigt wow wir sind alle ausspioniert, weil ein Hoster schneller ist als der andere.“

Falls Du mich bzw. uns (Hust!) damit gemeint haben solltest, dann erkläre bitte mal, wo ich (wir) das geschrieben habe.

AE-35